Dans la pénombre de la salle de cinéma de la National Film and Sound Archive (NFSA), dans une lumière oscillant entre le bleu Klein et un vert électrique qui fait surgir les reflets de bas-reliefs animaliers, une dame âgée monte sur l’estrade. L’écran derrière elle nous apprend qu’il s’agit d’Aunty Violet Sheridan, ancienne des Ngunnawal, et qu’elle est là pour nous accueillir. Ce message de bienvenue a vocation à protéger notre âme car, nous explique-t-elle, il ne nous viendrait jamais à l’idée d’entrer chez quelqu’un sans y être invité. La puissance de son message me fait encore frissonner. Une main tendue, certes, mais sans oublier la douleur d’une histoire dont nous héritons ensemble, et accompagnée d’un message d’espoir pour le futur, qui a aussi un goût d’avertissement, alors que l’Australie vient de célébrer le (triste) anniversaire du référendum concernant le « Indigenous voice to parliament« . Aucun.e australien.ne ne montera sur cette même estrade pendant ces deux jours sans saluer le peuple ngunnawal et les autres peuples aborigènes, reconnaître leur propriété des terres « où nous vivons et travaillons », et présenter ses respects à leurs aînés.

En débutant ainsi ce billet, je veux moi aussi adresser ma reconnaissance à Aunty Violet pour son accueil et aux peuples aborigènes des différentes terres que j’ai foulées. En tant qu’européenne, une des rares à avoir participé à cette édition australe de la conférence annuelle d’AI4LAM, j’ai vécu cet enjeu comme la secousse la plus importante, la plus riche en apprentissage de mon passage « down under« . L’intensité de ce qui se joue ici est difficilement perceptible sans faire le voyage, car comme l’évoquaient les collègues du projet IReal, le respect ne fait pas bon ménage avec l’urgence, et trouver un autre rapport culturel au temps et à l’espace implique de ralentir. Faire plus de vingt heures d’avion pour arriver à l’autre bout de la planète était une façon de me confronter à cette lenteur ; de renoncer à l’immédiateté permise par le numérique et la visioconférence et d’en faire l’expérience corporelle. La question de « comment on hérite » du passé colonial, en tant que personne mais aussi en tant qu’agent des institutions patrimoniales européennes, a été traversante pendant ces quelques jours, et je suis toujours à la recherche de mon douzième chameau*. C’est donc tout naturellement que je traiterai les « questions indigènes » (indigenous matters) en premier dans ma synthèse, avant d’aborder des thématiques plus classiques dans le paysage de l’intelligence artificielle.

« Data is land »

Cet aphorisme est revenu à plusieurs reprise ponctuer des conversations et présentations axées sur les enjeux de l’IA en lien avec les communautés indigènes en Australie et en Aotearoa-Nouvelle-Zélande. « Data is land« , c’est l’idée qu’il faut rendre aux communautés indigènes la gouvernance et la souveraineté sur leurs données, une approche qui pose problème pour des nations qui n’ont pas d’existence en tant qu’États et dont la culture emprunte d’autres voies que celles qui sont protégées par les lois occidentales. J’ai ainsi découvert le terme « ICIP » (Indigenous Cultural & Intellectual Property) : au-delà de notre bon vieux droit d’auteur moral et patrimonial, il s’agit de se pencher sur la question du respect du sacré, de la transmission générationnelle des savoirs et des cultures, de l’appartenance de ce patrimoine à la communauté de manière collective. Derrière ces concepts, l’idée clef est que ces communautés devraient avoir le contrôle sur la façon dont leur culture et les données afférentes sont utilisées, la possibilité de créer et gérer leurs propres archives, et la capacité à construire sur cette base des modèles de connaissance mais aussi des modèles économiques.

Ce dernier point est particulièrement important dans un contexte où, comme nous l’a rappelé Peter-Lucas Jones, la majorité des personnes incarcérées en Nouvelle-Zélande sont d’origine aborigène, et où cette forme de réparation vise des personnes qui ont été privées de leurs terres et de leurs ressources, vivant souvent dans une extrême pauvreté (je tiens de ma collègue canadienne assise à côté de moi que la situation est comparable pour les premières nations des Amériques). Dans ce contexte, l’éducation à l’IA (AI literacy) en direction de ces populations est d’autant plus cruciale, en termes d’égalité des chances notamment pour celles et ceux qui entrent à l’université.

Derrière ces principes, les actions concrètes incluent par exemple le recensement des données en lien avec les communautés indigènes dans les archives de l’ANU (Australia National University) pour permettre à ces communautés d’identifier les matériaux qui les concernent, la mise en place de partenariats avec les « big tech companies » (Microsoft et Amazon AWS) pour pallier l’absence de datacenters sur le territoire de la Nouvelle-Zélande, la mise en place d’actions de communication et de formation, l’adoption des principes CARE en plus des principes FAIR, ou encore la création de modèles d’IA adaptés aux langues à faibles ressources de ces communautés. Face à tous ces enjeux, les institutions patrimoniales sont vues comme des alliées… mais sans oublier que leurs collections se sont longtemps construites par la prédation d’objets venus d’autres cultures et de communautés qui se sont trouvées dépossédées de leur patrimoine (Peter-Lucas Jones a employé le terme très fort de « scavenging » ).

« Langage is culture »

« … and speech-to-text is invasion. » Je cite de nouveau Peter-Lucas Jones qui a un sacré sens de la formule ;-)

L’oralité tient en effet une place considérable dans les cultures locales, comme en témoigne l’existence d’un studio d’histoire orale au sein de la NLA (National Library of Australia) qui détient plus de 60.000 heures d’enregistrements et missionne 80 interviewers pour poursuivre ce travail. Cette collecte est considérée, au même titre que le dépôt légal des livres ou du web, comme une façon de faire entrer la culture australienne dans les collections. Les archives audiovisuelles tiennent aussi une place importante aux archives nationales d’Australie (NAA) et bien sûr, elles sont au cœur de l’activité de la NFSA. Rien d’étonnant, donc, à ce que l’un des usages de l’IA les plus mis en lumière à l’occasion de cette édition des « Futurs Fantastiques » ait été le speech-to-text.

Là aussi, le déplacement vers les contrées du Pacifique permet d’apporter une perspective différente. Kathy Reid nous a ainsi montré les variations importantes dans l’analyse des différents accents anglais par Whisper, le modèle ouvert d’OpenAI qui domine actuellement le marché et a été entraîné sur 680.000 heures de contenus issus d’Internet. Les écossais sont ceux dont l’accent est le moins bien reconnu, tandis que les australiens sont obligés d’imiter l’accent américain quand ils parlent à leur téléphone pour être compris ! La NFSA nous a montré, de son côté, comment elle apprenait à Whisper à parler l’australien, en générant d’abord des histoires truffées d’argot et de noms de lieux spécifiques, avant de les faire lire à haute voix par des locuteurs nationaux, de générer des transcriptions qui sont ensuite corrigées, et enfin utilisées pour entraîner le modèle. On retiendra que c’est une méthode sacrément « bikkie » (« bikkie » est l’argot australien pour « biscuit » mais pour une raison inconnue, l’IA générative semblait penser que ça voulait dire « génial » ;-)

Dans ce contexte, et plus encore s’agissant des langues indigènes qui n’étaient pas faites à l’origine pour être mises par écrit, l’enjeu des technologies IA qui traitent de la langue est important. Des benchmarks comme le Flores paper permettent d’évaluer le traitement des différentes langues, notamment celles qui sont considérées comme « à faibles ressources ». Mais la façon dont sont traitées les langues indigènes n’est pas toujours considérée par les personnes concernées comme satisfaisante (traductions approximatives, locuteurs non natifs…) et là aussi, l’enjeu est de leur permettre de reprendre la main sur leur langue et la façon dont elle est outillée avec l’IA. C’est une véritable « guerre des tokens » (l’expression est de Kathy Reid) qui s’annonce et dans laquelle la mise en place de politiques et de benchmarks jouera un rôle important.

L’an 2 après Kraken

Il arrive parfois que les conférences génèrent des gimmicks, des expressions heureuses qui percutent et s’installent, reprises d’un.e intervenant.e à l’autre. Celle-ci était particulièrement riche en la matière : quelqu’un a rappelé le tournant qu’a été la présentation au public de ChatGPT fin 2022, quelqu’un d’autre a évoqué cet événement comme étant l’avènement du « kraken » et à partir de là, tout le monde s’est mis à positionner ses projets en fonction d’une frontière temporelle symbolique : before or after Kraken.

Deux ans après Kraken, donc, la conférence est marquée par ces grands modèles qui se sont fait une place prépondérante dans le paysage. J’ai déjà parlé de Whisper, mais outre GPT-2, 3 et 4 (toujours OpenAI), il y a aussi LLAMA (de Facebook) et Mistral côté LLM, et dans le domaine de la vision artificielle, CLIP (toujours d’OpenAI) est revenu à plusieurs reprises ainsi que Florence-2 (de Microsoft).

Dans ce contexte, le cas d’usage que j’appellerais « anything-to-text » se précise. Qu’il s’agisse d’audio, de vidéo, d’images, d’écriture imprimée ou manuscrite, on a pu voir les exemples se multiplier, l’enjeu étant le passage à l’échelle ou l’industrialisation. En vrac :

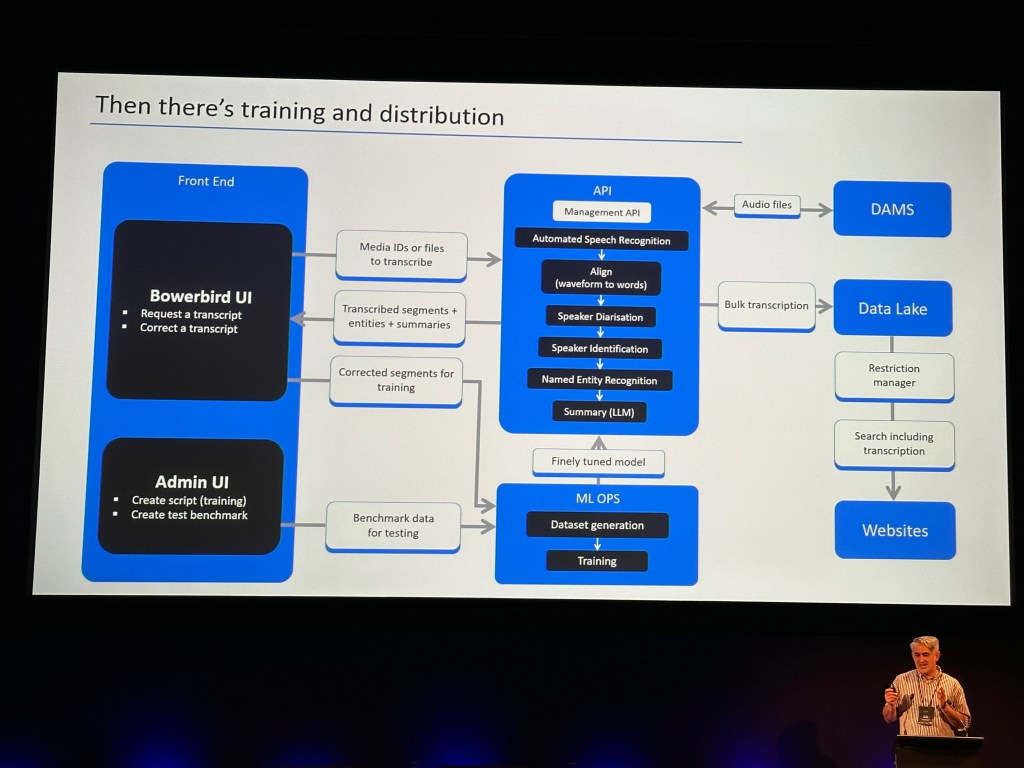

- la NFSA a créé Bowerbird, un moteur capable d’extraire le texte de contenu vidéo, associé à une interface de gestion des transcriptions (il a fallu 50 jours de traitement pour produire une première version transcrite de la totalité de la collection : 20 années linéaires de contenu)

- L’Université de Stanford a expérimenté la mise en place d’archives conversationnelles multimodales, utilisant le RAG et les intelligences artificielles génératives pour interroger des collections de photos et des archives concernant l’histoire de la Sillicon Valley

- la British Library travaille à l’industrialisation de ses workflows d’HTR, en travaillant notamment sur les écritures non latines,

- la Queensland Art Gallery a développé une application mobile permettant d’afficher les métadonnées d’un tableau en l’identifiant par similarité, l’entraînement du modèle étant intégré à l’application qui gère la sécurité des œuvres exposées

- le studio Kopi Su à Sydney propose à des musiciens d’expérimenter avec des systèmes d’IA générative musicale qui passent par le texte et l’image pour générer des sons

- le Los Alamos National Laboratory a testé l’amélioration des données d’autorité avec des LLM

- etc.

L’importance d’évaluer

Face à tous ces cas d’usages, un enjeu se fait particulièrement sentir cette année : celui de l’évaluation des résultats fournis par l’IA. Avec pour point de départ le workshop de la Library of Congress sur son AI planning framework (qui nous avait déjà été présenté plus rapidement l’an dernier), une question à se poser en amont est de savoir à quoi ressemblerait le succès quand on entreprend un projet IA. L’enquête présentée par Emily Pugh du Getty, par exemple, avait pour objectif de remonter aux sources des pratiques des historiens de l’art afin de comprendre comment les métadonnées générées par IA pourraient leur rendre service.

En aval, la construction de protocoles permettant de tester différents modèles et d’évaluer la qualité des résultats qu’ils produisent est actuellement une activité prépondérante dans la communauté**. C’était d’ailleurs l’objet de ma propre présentation, dans laquelle j’ai résumé les travaux conduits au Musée des Arts Déco par Marion Charpier, avec la contribution de Natacha Grim (TNAH power !) – je remercie aussi Jean-Philippe Moreux et Bénédicte Gady, respectivement expert et sponsor du projet, et si vous souhaitez en savoir plus, je vous renvoie à la présentation faite par Marion lors du dernier webinaire du chapitre francophone d’AI4LAM.

Je retiendrai en complément trois présentations particulièrement marquantes, qui ont abordé cette question de l’évaluation des résultats de l’IA.

En Norvège, le projet Mimir avait pour objectif de répondre à une question du gouvernement portant sur l’apport des œuvres protégées par le droit d’auteur à la qualité des réponses fournies par les LLM, lorsque ceux-ci sont entraînés à partir de telles œuvres. Pour cela, la National Library of Norway a mis au point un jeu de données permettant de différencier très finement plusieurs types de corpus (œuvres libres de droits, fiction et non-fiction, journaux…) de façon à identifier lesquels présentent l’apport le plus significatif pour entraîner un LLM à effectuer un certain nombre de tâches en matière de langage. L’évaluation a permis de montrer que les œuvres sous droit améliorent de façon certaine les résultats, mais que l’inclusion de corpus de fiction dans l’entraînement peut au contraire avoir un effet de détérioration de la qualité.

À l’Université d’Indiana aux USA, c’est le speech-to-text qu’il s’agissait d’évaluer, et en particulier les performances de différentes versions de Whisper, dans le contexte particulier des Etats-Unis où une loi oblige désormais les institutions à rendre accessibles les contenus audiovisuels en fournissant des transcriptions. Ici, l’enjeu était de tester l’extraction de texte sur une grande diversité de supports et de types de contenus, de manière à déterminer une approche générique.

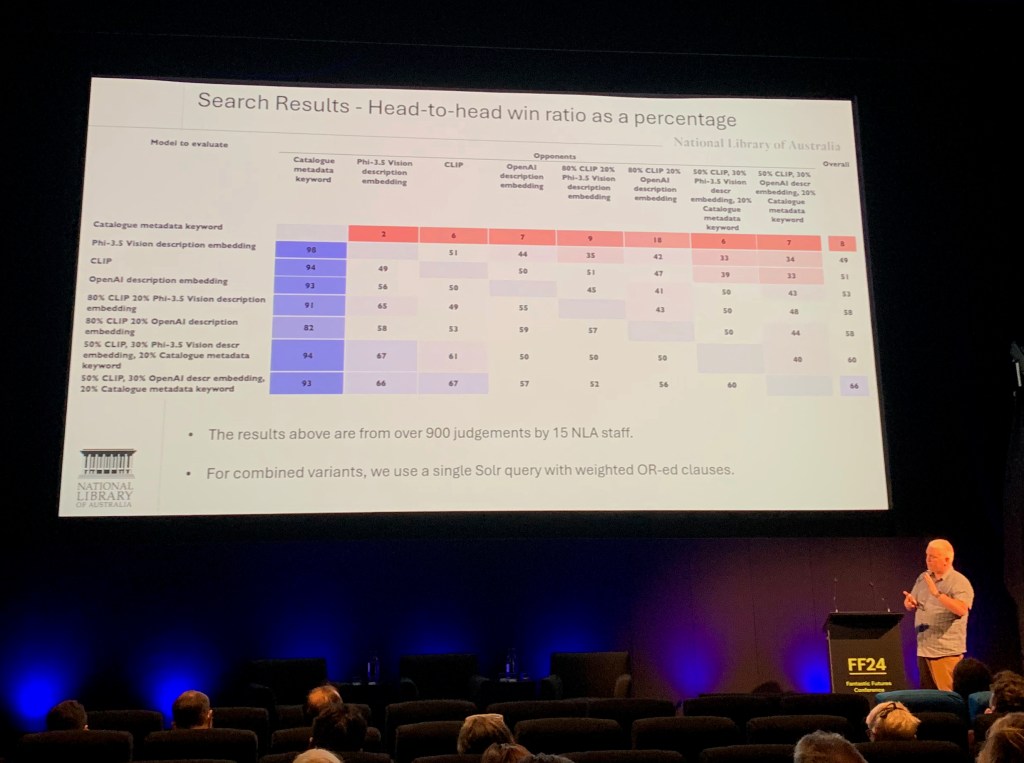

Enfin la NLA a également procédé à des tests, cette fois dans le domaine de la vision artificielle, l’objectif étant d’améliorer la découvrabilité des images dans Trove (équivalent australien de notre Gallica). Leur approche consiste à générer des descriptions des images avec un LLM de façon à permettre une recherche par mot-clefs, pas seulement sur des éléments iconographiques (ce que représente l’image) mais aussi des concepts comme des styles architecturaux, des ambiances, des émotions. Les descriptions générées permettent aussi de rapprocher des images qui se ressemblent (recherche par similarité et clustering) non pas en rapprochant directement les images, mais plutôt les textes générés. Pour cela, ces derniers sont transformés en vecteurs et injectés dans le moteur SolR qui sert d’outil d’accès. Trois modèles ont été comparés grâce à un protocole comprenant des questions types et une interface développée ad hoc (un peu façon Compar:IA) : CLIP et GPT-4 vision d’OpenAI, et Phi-3.5 vision de Microsoft.

Pour finir ces considérations sur l’évaluation, je voudrais mentionner l’enquête sur l’intégration des enrichissements de métadonnées (IA ou crowdsourcing) dans les bases de données de collections, réalisée par les partenaires du projet Collective Wisdom. Loin de dresser un paysage catastrophique, l’enquête révèle que la majorité des répondants sont parvenus, d’une manière ou d’une autre, à réinjecter les métadonnées enrichies dans leurs systèmes, la plupart du temps après une forme de contrôle qualité. Le principal obstacle en la matière réside moins dans les limitations techniques des formats et des systèmes (même si MARC a été mentionné !) que dans l’accord des parties prenantes sur la notion de qualité attendue de ces enrichissements.

Perspectives spatio-temporelles

Pour conclure, l’apport de la conférence de cette année résidait pour une part dans sa localisation originale, qui a apporté des perspectives nouvelles sur des enjeux de décolonisation, cruciaux dès lors qu’on s’intéresse à ces technologies et d’une façon plus générale, aux questions patrimoniales. Par ailleurs, la succession des conférences « futurs fantastiques » fournit une vision diachronique passionnante quant à l’intégration des questions d’IA dans les bibliothèques, les archives et les musées. Elle fait apparaître un effet de balancier, alternant les moments où la communauté expérimente tous azimuts et ceux où elle se met en quête de stabilisation et d’intégration des acquis dans ses processus et ses données. Cette année, le balancier penche de ce 2e côté et fournit de nombreuses inspirations pour qui veut conduire un projet d’IA en institution patrimoniale, en utilisant les modèles désormais disponibles.

Un grand merci aux organisateurs et organisatrices de cette très belle édition ! En attendant de revoir la conférence en vidéo, vous pouvez consulter les résumés des interventions sur la page du programme. Et sinon, rendez-vous l’an prochain à Londres pour de nouvelles aventures ! D’ici là, les webinaires mensuels de la communauté internationale sont ouverts à tous et toutes, ainsi que les réunions du chapitre francophone toutes les 6 semaines (la prochaine devrait avoir lieu le 19/11). Rejoignez-nous !

*Le douzième chameau fait référence à une fable citée par Vinciane Despret et Isabelle Stengers dans leur livre Les faiseuses d’histoires : que font les femmes à la pensée ? (La Découverte, 2011), dont je ne peux que recommander la lecture à toutes les femmes engagées dans des carrières universitaires.

**Cela me donne l’occasion de saluer l’actualité du projet Compar:IA, qui vient de voir le jour en France ! Et qui devrait d’ailleurs être à l’ordre du jour de la prochaine réunion du chapitre francophone d’AI4LAM.