Sur le modèle de ce que j’avais fait en 2023, voici mon bilan de recherche annuel : je précise que l’objectif principal de ce listing laborieux est 1) d’évaluer mon propre avancement sur une part de mon travail qui n’est pas évidente à mesurer et 2) d’avoir des données sous la main pour les évaluations Hcéres et autres. Au passage, cela permet de donner quelques nouvelles fraîches à défaut de blogging régulier ;-)

Mes sujets et projets de recherche

L’un des principaux défis, dans la liberté sans bornes qu’offre un poste d’enseignante-chercheuse, consiste à ne pas se disperser. Il y a tellement de sujets passionnants, de potentialités, d’invitations ! Il est assez facile de se retrouver en surcharge (surtout que généralement les engagements qu’on prend ne se concrétisent que plusieurs mois après). L’an dernier, j’avais donc décidé de concentrer mon effort sur deux pôles principaux : les archives du web d’une part, et l’intelligence artificielle dans les institutions patrimoniales d’autre part. Et cette décision a porté ses fruits !

Du côté des archives web, nous avons démarré deux projets de recherche jumeaux sur les skyblogs : Skybox et SkyTaste. Le premier est financé par la BnF dans le cadre de son plan quadriennal de la recherche, et le second par l’Université PSL via le dispositif Young Researcher Starting Grant (pour celles et ceux qui se demandent, les « jeunes » chercheurs et chercheuses sont des personnes qui ont soutenu leur thèse depuis moins de 7 ans et sont arrivées à PSL depuis moins de 2 ans, donc j’étais parfaitement dans les clous !) Les skyblogs seront donc, pour les 3 prochaines années, mon principal point d’entrée dans les archives web, notamment à travers l’encadrement de travaux étudiants comme celui d’Alice Guérin. Ce qui va me conduire à faire quelques infidélités à ce blog, puisque nous avons prévu de publier, avec les autres membres du projet, une série de billets mensuels sur le blog Webcorpora de la BnF.

Par ailleurs, je n’écarte pas complètement de mon périmètre d’autres objets connexes de l’histoire du web et du patrimoine numérique. En 2024, j’ai commencé mon premier co-encadrement de thèse avec Christophe Gauthier : il s’agit de la thèse de Christophe Carini-Siguret sur l’artification du jeu vidéo. La question du patrimoine vidéoludique gardera donc un poids important dans mes préoccupations ces prochaines années : cela se concrétise dès 2025 avec un colloque qui aura lieu à l’ENS et à l’ENC les 13 et 14 mai.

Du côté de l’intelligence artificielle, j’ai passé la main en tant que présidente d’AI4LAM, ce qui m’a permis de m’impliquer davantage d’une part dans le chapitre francophone, d’autre part dans le groupe de travail « Teaching and Learning ». Mais surtout, je pilote un autre projet financé cette fois par le Ministère de la culture à travers son appel FTNC : TORNE-H, porté par le Musée des Arts Déco et dont la chercheuse principale est Marion Charpier. L’objectif de cette recherche est de démontrer la valeur ajoutée des méthodes de computer vision pour analyser des collections muséales non décrites et d’étudier l’impact de l’intégration de l’IA dans les processus de travail du musée. Cela m’a aussi donné l’occasion de m’impliquer dans le consortium Huma-Num PictorIA, dont l’École des chartes est partenaire.

On est d’accord que tout ceci ne représente que 40 à 50% de mon temps de travail en moyenne, donc vous comprenez pourquoi il faut se mettre des limites…

Conférences, journées d’études, colloques…

L’année 2024 a de nouveau été bien riche en événements, avec pour commencer une série de conférences plus ou moins « grand public » sur l’intelligence artificielle dans les institutions patrimoniales. Cette thématique est liée à mon implication dans AI4LAM et pas vraiment à mon activité de recherche au sens strict mais notons-les ici quand même…

- Le 1er février, j’ai participé à la journée d’études « Ce que l’Intelligence Artificielle change à l’Université » organisée par la BU de Nantes et la chaire UNESCO RELIA. J’y ai donné une conférence introductive que vous pouvez revoir ici et j’ai contribué à faciliter un atelier conçu par Jean-Philippe Moreux sur la computer vision (support ici).

- Le 2 mai, j’ai été invitée par les bibliothèques de la ville de Paris à participer au festival Numok pour parler de l’IA en bibliothèque. La captation est disponible ici.

- Le 1er juillet, j’ai été invitée à participer aux « journée réseau » du SCD de l’université de Toulouse, un événement interne pour lequel j’ai proposé une conférence intitulée « Comment l’intelligence artificielle transforme la recherche documentaire ». Une répétition pour…

- … le 6 novembre, à Bordeaux, dans le cadre de la journée d’études « L’intelligence artificielle dans les espaces documentaires et bibliothéconomiques » organisée par l’INSPE de Bordeaux. La thématique était la même : « Comment l’intelligence artificielle transforme la recherche documentaire ». Mon support de présentation est accessible sur le site de la journée.

- enfin le 9 décembre, j’ai donné une conférence à l’ENC dans le cadre du cycle « Chartistes à l’œuvre » sur le thème « Intelligence artificielle et institutions patrimoniales » (captation vidéo).

Cette liste vous fournit plusieurs captations généralistes sur l’IA dans les institutions patrimoniales : j’ai donc décidé de ne plus accepter d’intervenir sur ce thème (parce qu’à partir d’un certain moment, ce n’est plus des conférences, c’est du théâtre…) pour me concentrer sur des approches plus spécifiques liées à TORNE-H en particulier.

Ainsi, d’autres événements ont donné lieu à des communications, soit dans le cadre d’AI4LAM, soit du projet TORNE-H, soit enfin dans le cadre du consortium Huma-Num PictorIA récemment créé (et parfois un peu des trois). Parmi ceux-ci :

- Le 24 janvier, nous avons présenté avec Marion Charpier une conférence intitulée « Using IIIF as an education tool in AI/ML for DH students » dans le cadre du groupe IIIF AI/ML qui joint les communautés AI4LAM et IIIF.

- Le 3 juin, le chapitre francophone AI4LAM a organisé une rencontre régionale à Strasbourg en partenariat avec la BNUS, sur le thème « Intelligence artificielle, patrimoine et humanités numériques ». J’y suis intervenue à deux voix avec Elsa Van Kote pour une présentation intitulée « Du master TNAH au réseau des MSH. Formation et services à la recherche autour de l’intelligence artificielle pour les humanités numériques » (compte-rendu et captation de la journée).

- Le 26 juin, avec Marion, nous avons animé un atelier PictorIA d’initiation à IIIF.

- Enfin le 7 novembre, j’étais à DH Nord ; la conférence portait cette année sur « Prospective et nouvelles perspectives en humanités numériques » et j’y ai présenté une intervention intitulée « Intelligence artificielle : enjeux et perspectives pour les institutions patrimoniales » (très original).

En plus de tout ça, il y a un événement un peu à part, car il va donner lieu à une publication : il s’agit des journées doctorales organisées conjointement par le Centre Jean-Mabillon et l’Université de Wuhan à l’École des chartes, les 19 et 20 septembre, sur le thème « Cultural Heritage and Digital Humanities ». En plus, j’y ai contribué à deux communications : la première avec Alexandre Faye sur le thème « Archiving the vernacular web: the example of skyblogs« , et la deuxième avec Marion Charpier intitulée “TORNE-H, an AI-based data processing worfklow for photographic collections”.

Je voudrais enfin faire une place à part aux deux grandes conférences internationales auxquelles j’ai participé cette année :

- la WAC (Web archiving conference) se tenait cette année à la BnF, du 24 au 26 avril. Un grand merci à mes ancien.ne.s collègues qui m’ont ainsi donné l’occasion de renouer avec la communauté IIPC qui travaille sur les archives du web. J’y ai animé la table-ronde d’ouverture, qui portait sur les skyblogs : « Here Ya Free! Crossed Views on Skyblog, the French Pioneer of Digital Social Networks« . La captation est à revoir à tout prix, c’était génial ! Avec ma collègue Valérie Schafer, nous avons aussi profité de cet événement pour organiser pendant les jours précédents une école de printemps pour les jeunes chercheurs et chercheuses sur les archives web (Early Scholars Spring School on Web Archives), un événement que nous avons prévu de répéter à l’avenir.

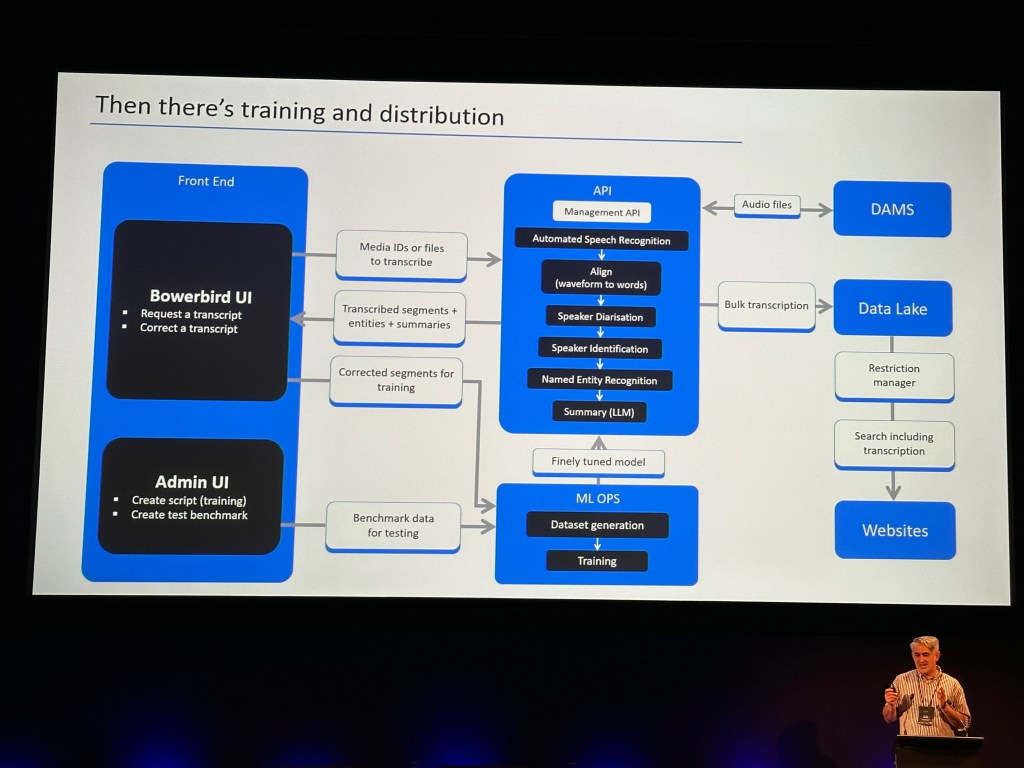

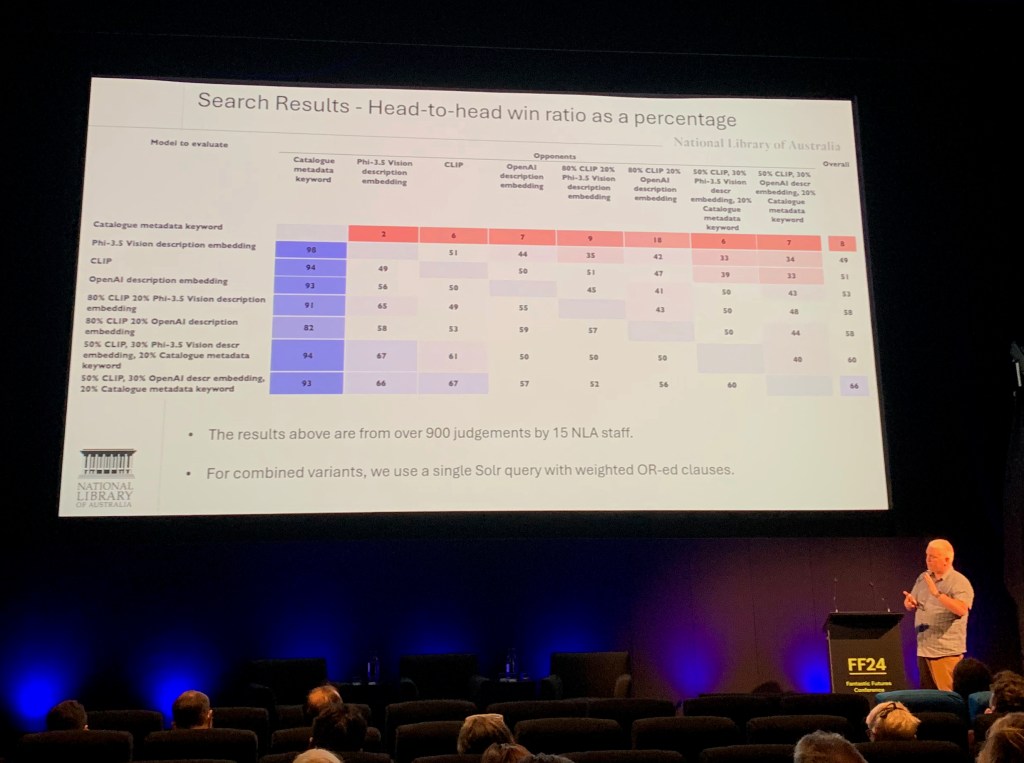

- La conférence annuelle d’AI4LAM, Fantastic Futures 2024, a eu lieu à Canberra en Australie (voir mon compte-rendu). Mon intervention, préparée conjointement avec Marion Charpier et Jean-Philippe Moreux, s’intitulait « Computer vision in the museum: perspectives at the MAD Paris » (captation).

Publications

Du côté des publications, l’événement de l’année c’était bien sûr le livre De l’écran à l’émotion, paru en juin 2024 aux éditions de l’École des chartes. Pas mal de choses se sont passées en périphérie de cette actualité éditoriale. Grâce à la complicité de Mélanie Leroy-Terquem, j’ai organisé le 2 octobre une présentation du livre à la BnF. J’ai aussi été interviewée dans Archimag et j’ai publié un article de vulgarisation dans The Conversation France.

Sinon, les actes du colloque RESAW de 2023 sont parus (Exploring the Archived Web during a Highly Transformative Age, sous la direction de Sophie Gebeil et Jean-Christophe Peyssard). Ils contiennent un article co-écrit avec Sara Aubry, Audrey Baneyx, Laurence Favier, Alexandre Faye, Marie-Madeleine Géroudet et Benjamin Ooghe-Tabanou : « A Network to develop the use of web archives: Three outcomes of the ResPaDon project« .

Un autre article collectif a été accueilli dans la revue Culture et Recherche sur recherche et intelligence artificielle paru cette année (n°147, automne-hiver 2024) au titre du chapitre francophone d’AI4LAM.

Pour finir, j’ai pulvérisé mon magnifique score de nombre de billets sur le blog (on était à 3 l’an dernier, on passe à 4 !!!) mais je ne citerai ici que celui qui contient du contenu original (hors compte-rendu de conférences) : « Le futur de la recherche documentaire : RAG time ! » S’y ajoute le billet sur le blog WebCorpora concernant les projets Skybox et SkyTaste. On va remettre le blogging à la mode ;-)

Activités diverses

S’il fallait vraiment lister TOUT ce que je fais au titre de la recherche… On pourrait ajouter la relecture d’articles en « peer-review » (pour la revue Humanités Numériques notamment), l’évaluation de projets de recherche (pour BELSPO), la participation à des comités scientifiques qui préparent les programmes et évaluent les réponses aux appels à contributions (Document numérique et société, WAC 2025, RESAW 2025), la participation au conseil scientifique d’Huma-Num et au comité d’orientation de l’Equipex Commons. Nous avons aussi passé pas mal de temps, avec Laurence Favier, Madeleine Géroudet et d’autres contributeurs et contributrices, à fignoler les actes du colloque ResPaDon, publiés en ce début d’année dans la revue LCN (mais ça comptera dans les publications de 2025 !)

Il faudrait aussi mentionner les directions de mémoire de master, qui ont inclus cette année en M1 les travaux d’Alice Guérin, de Sarah Ambec et de Juliette Benguigui, et les mémoires de M2 de Natacha Grim, Mohammed Mechentel, Kutay Sefil, Camille Ferrari, Elliot Fabert, Mathilde Prades, et Selma Bensidhoum (ce dernier en co-direction avec Émeline Levasseur). Merci à elles et à eux, et félicitations !

Pour finir sur une note moins boris-viannesque, je voudrais mentionner une dernière activité inclassable : une résidence que j’ai effectuée au sein du laboratoire C2DH de l’Université du Luxembourg, du 29 au 31 mai 2024, dans le cadre du dispositif Erasmus+ (oui ça existe aussi pour les profs !) C’était vraiment une expérience très chouette, j’ai appris beaucoup de choses et suis repartie avec plein d’idées pour mes projets. Un grand merci à Valérie Schafer, Frédéric Clavert et Benoît Majerus pour leur accueil !